DevOps i Cloud Architect

11 grudnia 2024

Introduction

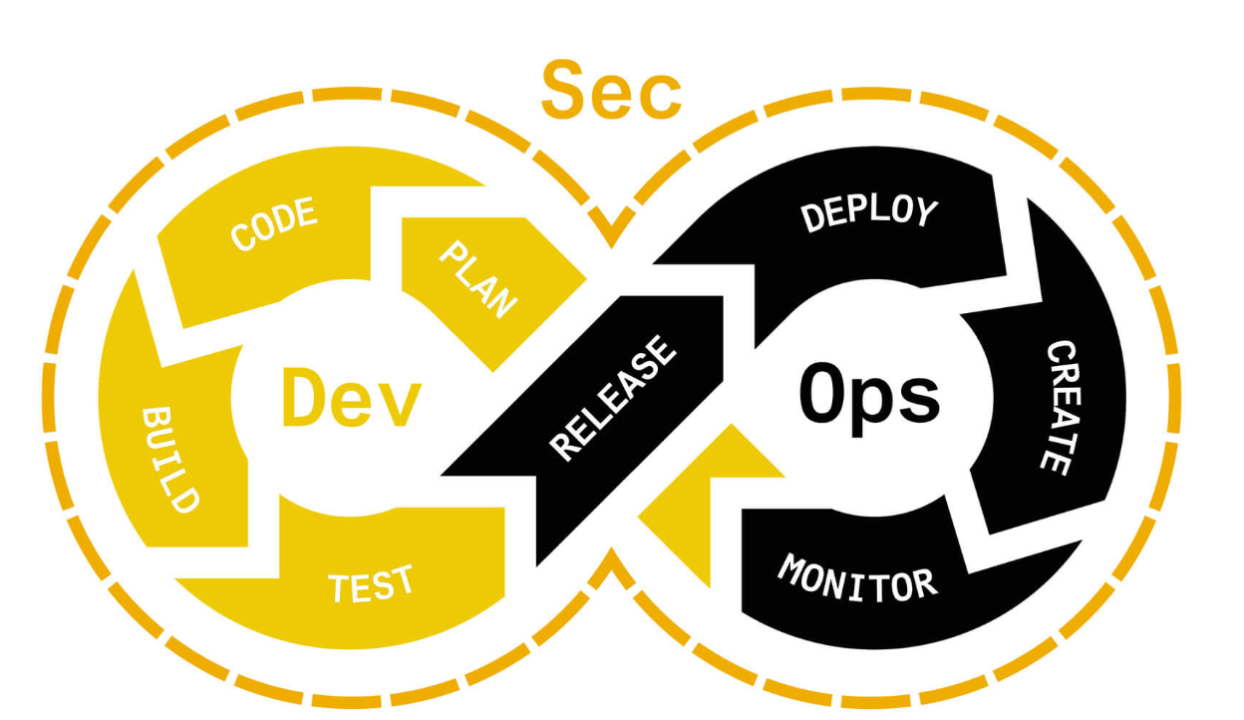

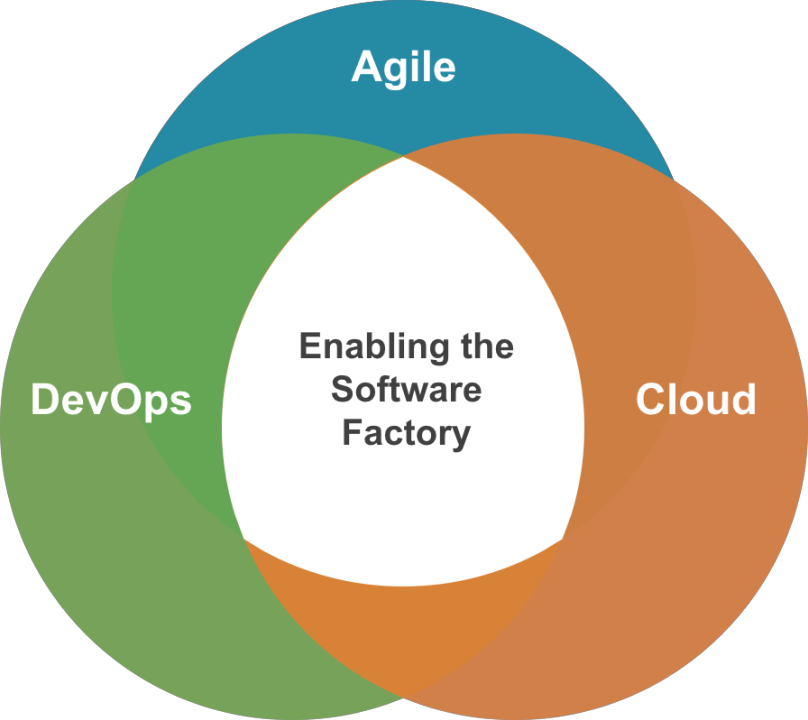

Azure DevOps is a comprehensive platform that facilitates application lifecycle management, offering tools for version control, requirement management, build automation, testing, and release management. In the DevOps context, the primary goal is to automate and streamline the deployment process to deliver new features faster and with higher quality. In this article, I will discuss the practical implementation of CI/CD pipelines in Azure DevOps, and how Terraform supports these processes through an Infrastructure as Code (IaC) approach.

What is Azure DevOps and Why Should You Use It?

Azure DevOps is a set of tools that integrate various stages of software development into a single, automated process. CI/CD pipelines form the backbone of DevOps, enabling the automated building, testing, and deployment of code to testing, production, and other environments. The key aspects of Azure DevOps include:

– Continuous Integration (CI): Integrating code changes into a shared repository continuously, allowing for quick detection of issues.

– Continuous Delivery (CD): Automating the deployment process to ensure quick and reliable delivery to users.

Creating a Pipeline in Azure DevOps

The foundation of a CI/CD pipeline in Azure DevOps is a YAML file, which defines the steps for building, testing, and deploying the application. Below, I outline the main steps and elements that should be included in the pipeline:

– Version Control Definition: Azure DevOps provides version control via GIT, which allows tracking of changes in both code and infrastructure configurations.

– Automated Build: The build process can include steps such as compilation and running unit and integration tests.

– Testing: Testing is critical in the CI/CD process. Unit, integration, and functional tests can be automatically run during the pipeline.

– Deployment (Release): The release pipeline is responsible for deploying the application to production or other environments. Azure DevOps supports deployments to platforms like Azure App Services, Azure Kubernetes Service (AKS), and others.

Terraform and Azure DevOps: Infrastructure as Code (IaC)

Terraform is a tool for managing infrastructure using an IaC model, which allows the automation of creating and managing environments. Using Terraform in Azure DevOps enables:

– Infrastructure Management: Defining infrastructure in configuration files (e.g., main.tf) that can be versioned and shared within the team. Resources such as VMs, App Services, or Kubernetes can be defined here.

– Simplified Workflow: Terraform plans, creates, and updates resources according to the defined state (`terraform plan`, terraform apply). This helps quickly detect discrepancies between the actual and desired state.

– Modularity and Reusability: Terraform supports modules, enabling you to create resource sets that can easily be reused across environments. For example, you can create a module for deploying an Azure App Service and use it in multiple projects.

Implementing CI/CD Pipelines in Azure DevOps with Terraform: A Practical Approach\

General Outline of the Pipeline

The CI/CD pipeline described here consists of two stages: Plan and Deploy. The pipeline combines best practices for code versioning, validation, and infrastructure deployment through Terraform.

The pipeline is structured in a YAML file, making it easy to edit, version, and reuse. Below is a detailed description of each stage.

Pipeline Parameters\

In the parameters section, we specify the environment selection (e.g., DEV, TEST, PRE, PROD) and an optional Terraform deployment (`boolean deployTerraform`). These parameters allow for dynamic pipeline adjustment, making it more versatile and easier to use across different environments.

parameters:

- name: environment

displayName: "Select an environment"

type: string

default: "DEV"

values:

- "DEV"

- "TEST"

- "PRE"

- "PROD"

- name: deployTerraform

displayName: "Deploy Terraform?"

type: boolean

default: false

Stage 1: Planning (Plan Stage)

The first stage, called „Validate and Plan Terraform,” consists of several key steps. The goal of this stage is to prepare a Terraform action plan, which will be approved before moving to the deployment stage.

– Install Terraform: In this step, the pipeline installs the latest version of Terraform.

– Create „: Next, the pipeline generates a backend.tf file, which contains the backend configuration for Terraform (`backend „azurerm”`). Values such as resource_group_name, storage_account_name, and subscription_id are drawn from the variable definitions.

– Validation and Planning: Finally, the pipeline runs terraform init and terraform plan commands to create a detailed deployment plan for the selected environment.

stages:

- stage: Plan

displayName: 'Validate and Plan Terraform'

jobs:

- job: Plan

displayName: 'Plan Terraform'

steps:

- checkout: self

- task: ms-devlabs.custom-terraform-tasks.custom-terraform-installer-task.TerraformInstaller@0

displayName: 'Install Terraform'

inputs:

terraformVersion: 'latest'

- task: Bash@3

displayName: 'Run Terraform Plan'

inputs:

targetType: 'inline'

script: |

cat > backend.tf <<EOL

terraform {

backend "azurerm" {

resource_group_name = "$(backendAzureRmResourceGroupName)"

storage_account_name = "$(backendAzureRmStorageAccountName)"

container_name = "$(backendAzureRmContainerName)"

key = "$(backendAzureRmKey)"

subscription_id = "$(backendAzureRMSubscriptionID)"

tenant_id = "$(terraform_app_tenant_id)"

}

}

EOL

terraform init && terraform plan -var-file=environments/${{parameters.environment}}.tfvars

Stage 2: Deployment (Deploy Stage)

The second stage, called „Deploy Terraform,” is a conditional stage that can be run if the deployTerraform parameter is set to true. In this stage, manual validation of the previous step’s results is also required before proceeding.

– Manual Validation: Before moving to the actual deployment, manual validation is required. Stakeholders must confirm that the plan results align with expectations.

– Deploy Terraform Configuration: After approval, the pipeline continues by installing Terraform and running terraform apply to implement the prepared infrastructure.

- stage: Deploy

displayName: 'Deploy Terraform'

condition: and(succeeded(), eq('${{parameters.deployTerraform}}', true))

jobs:

- job: WaitForApproval

displayName: 'Wait for validation approval'

pool: server

steps:

- task: ManualValidation@0

displayName: 'Wait for validation'

inputs:

notifyUsers: '$(PipelineValidators)'

instructions: 'Please review the output of the plan stage before proceeding.'

- job: Deploy

displayName: 'Deploy Terraform Configurations'

dependsOn: WaitForApproval

steps:

- task: ms-devlabs.custom-terraform-tasks.custom-terraform-installer-task.TerraformInstaller@0

displayName: 'Install Terraform'

inputs:

terraformVersion: 'latest'

- task: Bash@3

displayName: 'Run Terraform Apply'

inputs:

targetType: 'inline'

script: 'terraform init && terraform apply -auto-approve'

This CI/CD pipeline in Azure DevOps, using Terraform, is a powerful tool for managing infrastructure as code. It automates planning, validation, and deployment of infrastructure changes, ensuring consistency, repeatability, and high-quality deployments.

The parameterization and manual validation add flexibility and control over the deployment process, which is especially important in production projects where every change can have significant consequences. Terraform as an infrastructure management tool is an excellent choice, allowing not only resource definition but also versioning and easy scaling.

Benefits of Using Azure DevOps and Terraform

– Automation and Repeatability: Both Terraform and Azure DevOps support automation, allowing for consistent, repeatable deployment of changes in infrastructure and applications.

– Version Control: Terraform supports version control, enabling precise tracking of changes in infrastructure configuration and easy rollback if needed.

– Scalability and Modularity: With Terraform modules, managing complex infrastructure is easier, which increases flexibility when creating and maintaining resources.

Challenges and Best Practices

– Security: Terraform stores the state of the infrastructure, which may contain sensitive information. It is recommended to store state in secure locations, such as Azure Storage with access controls.

– Module Versioning: Using modules helps with reusability but also requires proper versioning to avoid compatibility issues.

– Monitoring and Alerts: In the DevOps context, monitoring the infrastructure and setting appropriate alerts is key. Tools like Coralogix and Prometheus can be used to monitor deployments.

Conclusion: Azure DevOps and Terraform are powerful tools that enable the full automation of both application and infrastructure deployments. The integration of these tools allows development teams to make changes more quickly and respond rapidly to user needs. The key to success in implementing CI/CD pipelines is to follow best practices, such as modularity, versioning, and appropriate security management.